Объем в информатике. Вопрос1.Базовые понятия: сообщения, сигнал, информация, свойства информации, информатика

Количественные характеристики информации

Классификация мер информации представлена на рис.1.

Рис. 1. Классификация мер информации

Синтаксическая мера информации оперирует с обезличенной информацией, не выражающей смыслового отношения к объекту. На синтаксическом уровне учитываются тип носителя и способ представления информации, скорость передачи и обработки, размеры кодов представления информации.

Существуют два основных подхода в определении количества информации. Исторически они возникли почти одновременно. В конце 40-х г. XX века один из основоположников кибернетики, американский математик Клод Шеннон развил вероятностный подход к измерению количества информации, а работы по созданию ЭВМ привели к «объемному» подходу.

Объём данных (V Д) понимается в техническом смысле этого слова как информационный объём сообщения или как объём памяти, необходимый для хранения сообщения без каких-либо изменений.

Информационный объём сообщения измеряется в битах и равен количеству двоичных цифр (“0” и “1”), которыми закодировано сообщение.

В компьютерной практике слово “бит” используется также как единица измерения объёма памяти. Ячейка памяти размером в 1 бит может находиться в двух состояниях (“включено” и “выключено”) и в неё может быть записана одна двоичная цифра (0 или 1). Понятно, что бит – слишком маленькая единица измерения информации, поэтому пользуются кратными ей величинами. Основной единицей измерения информации является байт . 1 байт равен 8 битам. В ячейку размером в 1 байт можно поместить 8 двоичных цифр, то есть в одном байте можно хранить 256 = 2 8 различных чисел. Для измерения ещё больших объёмов информации используются следующие величины:

1 Кбайт (один килобайт) = 2 10 байт = 1024 байта (1 kB );

1 Мбайт (один мегабайт) = 2 10 Кбайт = 1024 Кбайта (1 MB );

1 Гбайт (один гигабайт) = 2 10 Мбайт = 1024 Мбайта (1 GB );

1 Тбайт (один терабайт) = 2 10 Гбайт = 1024 Гбайта (1 TB );

1 Пбайт (один петабайт) = 2 10 Тбайт = 1024 Тбайта (1 PB );

1 Эбайт (один эксабайт) = 2 10 Пбайт = 1024 Пбайта (1 EB );

1 Збайт (один зеттабайт) = 2 10 Эбайт = 1024 Эбайта (1 ZB );

1 Йбайт (один йоттабайт) = 2 10 Збайт = 1024 Збайта (1 YB ).

Пример 1 . При двоичном кодировании текста каждая буква, знак препинания, пробел занимают 1 байт. На странице книги среднего формата примерно 50 строк, в каждой строке около 60 символов, таким образом, полностью заполненная страница имеет объём 50x60= = 3000 байт ≈3 Килобайта. Вся книга среднего формата занимает ≈0,5 Мегабайт. Один номер четырёхстраничной газеты – 150 Килобайт. Если человек говорит по 8 часов в день без перерыва, то за 70 лет он наговорит около 10 Гигабайт информации. Один чёрно-белый кадр (при 32 градациях яркости каждой точки) содержит примерно 300Кб информации, цветной кадр содержит уже около 1Мб информации. Телевизионный фильм продолжительностью 1,5часа с частотой 25 кадров в секунду - 135 Гб.

При вероятностном подходе количество информации I на синтаксическом уровне определяется через понятие энтропии системы.

Пусть до получения информации потребитель имеет некоторые предварительные (априорные) сведения о системе α. Мерой его неосведомленности о системе является функция H(α), которая в то же время служит и мерой неопределенности состояния системы.

После получения некоторого сообщения β получатель приобрел некоторую дополнительную информацию I β (α), уменьшившую его априорную неосведомленность так, что неопределенность состояния системы после получения сообщения β стала H β (α).

Тогда количество информации I β (α) о системе, полученной в сообщении β, определится как

I β (α) = H(α) - H β (α).

т.е. количество информации измеряется изменением (уменьшением) неопределенности состояния системы. Если конечная неопределенность H β (α) обратится в нуль, то первоначальное неполное знание заменится полным знанием и количество информации будет определяться как I β (α) = H(α). Иными словами, энтропия системы Н(а) может рассматриваться как мера недостающей информации.

Энтропия системы H(α), имеющая N возможных состояний, согласно формуле Шеннона, равна:

где – вероятность того, что система находится в i-м состоянии. Для случая, когда все состояния системы равновероятны, т.е. их вероятности равны, ее энтропия определяется соотношением:

Пример 2. Часто информация кодируется числовыми кодами в той или иной системе счисления, особенно это актуально при представлении информации в компьютере. Естественно, что одно и то же количество разрядов в разных системах счисления может передавать разное число состояний отображаемого объекта, что можно представить в виде соотношения

N = m n ,где N – число всевозможных отображаемых состояний;

m – основание системы счисления (разнообразие символов, применяемых в алфавите);

n – число разрядов (символов) в сообщении.

Допустим, что по каналу связи передается n-разрядное сообщение, использующее m различных символов. Так как количество всевозможных кодовых комбинаций будет N = m n , то при равновероятности появления любой из них количество информации, приобретенной абонентом в результате получения сообщения, будет определяться по формуле Хартли:

I = log N = n log m

Если в качестве основания логарифма принять m, то I = n. В данном случае количество информации (при условии полного априорного незнания абонентом содержания сообщения) будет равно объему данных I = V Д, полученных по каналу связи.

Наиболее часто используются двоичные и десятичные логарифмы. Единицами измерения в этих случаях будут соответственно бит и дит .

Семантическая мера информации

Для измерения смыслового содержания информации, т.е. ее количества на семантическом уровне, наибольшее признание получила тезаурусная мера, которая связывает семантические свойства информации со способностью пользователя принимать поступившее сообщение. Для этого используется понятие «тезаурус пользователя» .

Тезаурус – это совокупность сведений, которыми располагает пользователь или система.

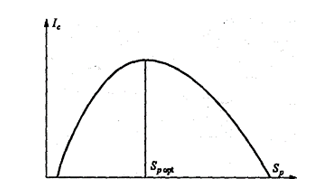

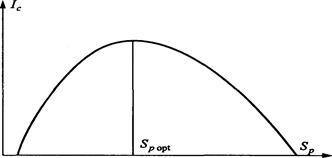

В зависимости от соотношений между смысловым содержанием информации S и тезаурусом пользователя S p изменяется количество семантической информации I c , воспринимаемой пользователем и включаемой им в дальнейшем в свой тезаурус. Характер зависимости количества семантической информации, воспринимаемой потребителем, от его тезауруса показан на рис. 2.

Рис. 2. Характер зависимости количества семантической информации от его тезауруса

Рассмотрим два предельных случая, когда количество семантической информации I c равно 0:

При пользователь не воспринимает и не понимает поступающую информацию;

При пользователь все знает, и поступающая информация ему не нужна.

Максимальное количество семантической информации I c потребитель приобретает при согласовании ее смыслового содержания S со своим тезаурусом S p (S p = S p opt), когда поступающая информация понятна пользователю и несет ему ранее не известные (отсутствующие в его тезаурусе) сведения. Следовательно, количество семантической информации в сообщении, т.е. количество новых знаний, получаемых пользователем, является величиной относительной. Одно и то же сообщение может иметь смысловое содержание для компетентного пользователя и быть бессмысленным для пользователя некомпетентного.

Относительной мерой количества семантической информации может служить коэффициент содержательности С , который определяется как отношение количества семантической информации к ее объему: .

Прагматическая мера информации (аксиологический подход)

Эта мера определяет полезность информации (ценность) для достижения пользователем поставленной цепи. Эта мера также является величиной относительной, обусловленной особенностями использования этой информации в той или иной системе.

Ценность информации целесообразно измерять в тех же самых единицах (или близких к ним), в которых измеряется целевая функция.

Представим для сопоставления введённые меры информации в таб. 1.

Таб. 1. Меры информации

![]()

Сообщения - совокупность знаков, отображающих ту или иную информацию.

Сигнал - физический процесс, отображающий (несущий) передаваемое сообщение.

Инф-я - вся совокупность сведений об окр. нас мире, о всевозможных протекающих в нём процессах, кот. мб восприняты живыми организмами, электр.машинами и др. информационными системами.

Свойства :

1) Объективность : объективно-существующая вне и независимо от человеч. сознания. Информация объективна, если она не зависит от методов ее фиксации, чьего-либо мнения.

2) Достоверность : отражает истинные положения дел.

3) Полезность : п. мб оценена применительно к людям, к нуждам конкретных её потребителей. Зависит от времени и объекта.

4) Актуальность : важна для настоящего времени. Только вовремя полученная информация мб полезна.

5) Точность : определяется степенью её близости к реальному состоянию объекта, процесса.

6) Полнота : достаточна для понимания и принятия решения.

7) Понятность : выражена на языке, доступном получателю.

Информатика - наука, изучающая структуру и наиболее общие св-ва информации, ее поиск, хранение, передачу и обработку с применением ЭВМ.

Вопрос2. Модели баз данных. Реляционная модель.

База данных - это информационная модель, позволяющая упорядоченно хранить данные о группе объектов, обладающих одинаковым набором свойств.Ядром любой базы данных является модель данных. Модель данных – это совокупность структур данных и операций их обработки. Существует три основных типа моделей данных : иерархическая, сетевая и реляционная.

Иерархическая модел ь данных представляет собой совокупность элементов данных, расположенных в порядке их подчинения и образующих по структуре перевернутое дерево.

Сетевая модель данных похожа на иерархическую модель, но в сетевой модели каждый элемент мб связан с любым другим элементом.

Наиболее популярной с начала 80-х гг. была и до сих пор остается реляционная модель данных. Реляционная модель данных использует организацию данных в виде двумерных таблиц. Каждая такая таблица, называемая реляционной таблицей или отношением, представляет собой двумерный массив и обладает следующими свойствами :

1.все столбцы в таблице однородные, т.е. все элементы в одном столбце имеют

одинаковый тип и максимально допустимый размер;

2.каждый столбец имеет уникальное имя;

3.одинаковые строки в таблице отсутствуют;

4.порядок следования строк и столбцов в таблице не имеет значения.

Основными структурными элементами реляционной таблицы являются поле и запись. Поле (столбец реляционной таблицы) – элементарная единица логической организации данных, которая соответствует конкретному атрибуту информационного объекта. Запись (строка реляционной таблицы) – совокупность логически связанных полей, соответствующая конкретному экземпляру информационного объекта.

Вопрос3.Меры и единицы количества и объема информации. Кодирование данных в эвм.

Меры информации :

-синтаксическая - мера кол-ва инф., которая оперирует с обезличенной информацией, не выражающей смыслового отношения к объекту, на синтаксическом уровне учитываются тип носителя и способ представления информации , скорость передачи и обработки , размеры кодов представления информации.

-семантическая -используется для измерения смыслового содержания информации.для измерения количества смыслового содержания информации наибольшее признание получила тезаурусная мера, которая связывает семантические свойства информации со способностью пользователя принимать поступившее сообщение. Для этого используется понятие «тезаурус пользователя» . Тезаурус – это совокупность сведений, которыми располагает пользователь или система.

-прагматическая - определяет полезность информации(ценность) для достижения пользователем поставленной цели. Эта мера также является величиной относительной (обусловленной особенностями использования этой информации в той или иной системе)

Основная единица измерения информации - бит. Бит – минимальная единица измерения кол-ва информации, соответствующая одной двоичной цифре («0» или «1»).

Единицы : -1байт=8бит; -1Килобайт=2^10=1024байт; -1Мегобайт=2^20байт; -1Гигобайт=2^30байт; -1Терабайт=2^40байт; -1Петабайт=2^50байт.

ЭВМ - электронное уст-во, используемое для автоматизации процессов приема, хранения, обработки и передачи инф., которые осуществляются по разработанным человеком алгоритмам.

В ЭВМ применяется двоичная система счисления, т.е. все числа в компьютере представляются с помощью 0 и 1(двоичные цифры), поэтому компьютер может обрабатывать только информацию, представленную в цифровой форме. Для преобразования числовой, текстовой, графической, звуковой информации в цифровую необходимо применить кодирование. Кодирование – это преобразование данных одного типа через данные другого типа (преобразование инф. в форму пригодную для передачи по определенному каналу связи).Целые числа кодируются двоичным кодом довольно просто (путем деления числа на два). Для кодирования нечисловой информации используется следующий алгоритм: все возможные значения кодируемой информации нумеруются и эти номера кодируются с помощью двоичного кода.

Единицы измерения информации служат для измерения объёма информации.

В простейшем случае чтобы отличить одно от других необходимо наличие двух информационных объектов. Причем сами такие объекты должны быть неделимыми, как атомы. В таком случае одному такому объекту можно ставить в соответствие, например, число, 0, а другому 1. Нельзя придумать иных элементарных отличий. К примеру, черно-белый объект может быть лишь в двух состояниях – черный или белый. Можно говорить о других бинарных состояниях объектов - включен/выключен, есть/нет. Такие состояния обладают минимальной информационной ёмкостью.

Для измерения количества информации необходима единица информации. За единицу количества информации приняли такое количество информации, при котором неопределённость уменьшается в два раза. Такая единица названа бит . Информационный объем сообщения - количество двоичных символов, используемое для кодирования этого сообщения. Информационная ёмкость одной ячейки памяти компьютера, способной находиться в двух различных состояниях, принята за единицу измерения количества информации - 1 бит.

Бит – это один двоичный разряд 1 или 0. Байт – 8 двоичных разрядов. 1 байт = 8 бит.

Каждое из 256 двоичных чисел

имеет размер 1 байт.

С их помощью занумеровать и различать 256 различных объектов.

Производные единицы измерения информации и данных:

1 Кб (1 Килобайт ) = 2 10 байт = 1024 байт

1 Мб (1 Мегабайт ) = 2 20 байт = 1024 килобайт

1 Гб (1 Гигабайт ) = 2 30 байт = 1024 мегабайт

1 Тб (1 Терабайт ) = 2 40 байт = 1024 гигабайт.

1 Пб (1 Петабайт ) = 2 50 байт = 1024 терабайт.

1 Эксабайт = 2 60 байт = 1024 петабайт.

1 Зеттабайт = 2 70 байт = 1024 эксабайт.

1 Йоттабайт = 2 80 байт = 1024 зеттабайт.

Конец работы -

Эта тема принадлежит разделу:

ТЕМА 1. ИНФОРМАЦИЯ И ИНФОРМАТИКА

Информация в материальном мире Сигналы и данные Мы живем в материальном мире Все что нас... Пример процесса преобразования данных в информацию...

Если Вам нужно дополнительный материал на эту тему, или Вы не нашли то, что искали, рекомендуем воспользоваться поиском по нашей базе работ:

Что будем делать с полученным материалом:

Если этот материал оказался полезным ля Вас, Вы можете сохранить его на свою страничку в социальных сетях:

| Твитнуть |

Все темы данного раздела:

Сигналы и данные

Мы живем в материальном мире.

Все, что нас окружает и с чем мы сталкиваемся ежедневно, относится либо к физическим телам, ли

Данные и методы

Данные несут в себе информацию о событиях, произошедших в материальном мире. Однако данные не тождественны информации.

Наблюдая излучения да

Понятие об информации

Несмотря на то, что с понятием информации мы сталкиваемся ежедневно, строгого и общепризнанного определения информации до сих пор не существует, поэтому вмес

Взаимодействие данных и методов

Данные являются объективными, поскольку это результат регистрации объективно существовавших сигналов, вызванных изменениями в материальных телах или полях.

Актуальность.

1. Объективность и субъективность информации. Понятие объективности информации является относительным. Это понятно, если учесть, что методы являются субъективными.

Истоки и предпосылки информатики

Слово информатика происходит от французского слова Informatique, образованного в результате объединения терминов Information (информация) и

Двоичная система счисления

впервые предложена гениальным немецким математиком и инженером Готфридом Лейбницем, изобретателем систем счисления, а также основателем дифференциального и интегрального исчи

Троичная система счисления

Из целочисленных систем счисления обладает наибольшей плотностью записи информации.

Первая троичная ЭВМ «Сетунь» была построена в 1958 году Н. П. Брусенцовым в МГУ.

Позиционные системы счисления

Позиционная систе́ма счисле́ния (позиционная нумерация) - система счисления, в которой значение каждого числового знака (цифры) в записи числа зависит от его позиции (раз

Представление числа

Целое число без знака в системе счисления представляется в виде конечной линейной комбинации степеней числа

Запись числа

Число записывают в виде последовательности его -ричных цифр, перечисляемых по убыва

Перевод вещественного числа из десятичной системы счисления в двоичную систему

Рассмотрим число 567.25 и переведем его в двоичную систему счисления.

Перевод целого числа из десятичной системы счисления в двоичную систему

Перевод дробной части числа

Имеем аналогично

0.012 = 0*2-1+1*2-2 = 0*0.5+1*0.25 = 0.25.

Окончательно получим

1000110111.012 = 567.

Кодирование текстовых данных

Если каждому символу алфавита сопоставить определенное целое число (например, порядковый номер), то с помощью двоичного кода можно кодировать и текстовую информацию. Восьми двоичных

Кодирование графических данных

Если рассмотреть с помощью увеличительного стекла черно-белое графическое изображение, напечатанное в газете или книге, то можно увидеть, что оно состоит из мельчайших точек, образу

Кодирование звуковой информации

Можно выделить два основных направления.

Метод FM (Frequency Modulation) основан на том, что теоретически любой сложный звук при помощи преобразован

Кодирование видеоинформации

Изображение в видео состоит из отдельных кадров, которые меняются с определенной частотой. Кадр кодируется как обычное растровое изображение, то есть разбивается на множество пикселей. Закодировав

Видеоформаты и видеостандарты

В первую очередь определимся с видеостандартами. Их обязательно нужно учитывать при создании видеофильма или видеоролика.

PAL - видеостанд

Стандарты сжатия цифрового видео

MPEG - один из основных стандартов сжатия. Аббревиатура MPEG (Moving Pictures Expert Group) - это название международного комитета, занимающегося разработкой данного стандарта сжат

Расширения видеофайлов

AVI (Audio-Video Interleaved) - это расширение огромного количества видеофайлов, но не является форматом или кодеком. Это контейнер, разработанный

Алгебра логики

Логика очень древняя наука. Ещё в античные времена была известна формальная логика, позволяющая делать заключения о правильности какого-либо суждения не по его фактическому содержан

При реализации информационных процессов всегда происходит перенос информации в пространстве и времени от источника информации к приемнику (получателю). При этом для передачи информации используют различные знаки или символы, например естественного или искусственного (формального) языка, позволяющие выразить ее в некоторой форме, называемой сообщением.

Сообщение – форма представления информации в виде совокупности знаков (символов), используемая для передачи.

Сообщение как совокупность знаков с точки зрения семиотики (от греч. setneion - знак, признак ) – науки, занимающейся исследованием свойств знаков и знаковых систем, - может изучаться на трех уровнях:

1) синтаксическом , где рассматриваются внутренние свойства сообщений, т. е. отношения между знаками, отражающие структуру данной знаковой системы. Внешние свойства изучают на семантическом и прагматическом уровнях. На этом уровне рассматривают проблемы доставки получателю сообщений как совокупности знаков, учитывая при этом тип носителя и способ представления информации, скорость передачи и обработки, размеры кодов представления информации, надежность и точность преобразования этих кодов и т. п., полностью абстрагируясь от смыслового содержания сообщений и их целевого предназначения. На этом уровне информацию, рассматриваемую только с синтаксических позиций, обычно называют данными, так как смысловая сторона при этом не имеет значения.

Современная теория информации исследует в основном проблемы именно этого уровня. Она опирается на понятие «количество информации», являющееся мерой частоты употребления знаков, которая никак не отражает ни смысла, ни важности передаваемых сообщений. В связи с этим иногда говорят, что современная теория информации находится на синтаксическом уровне.

2) семантическом , где анализируются отношения между знаками и обозначаемыми ими предметами, действиями, качествами, т. е. смысловое содержание сообщения, его отношение к источнику информации. Проблемы семантического уровня связаны с формализацией и учетом смысла передаваемой информации, определения степени соответствия образа объекта и самого объекта. На данном уровне анализируются те сведения, которые отражает информация, рассматриваются смысловые связи, формируются понятия и представления, выявляется смысл, содержание информации, осуществляется ее обобщение.

3) прагматическом , где рассматриваются отношения между сообщением и получателем, т. е. потребительское содержание сообщения, его отношение к получателю.

На этом уровне интересуют последствия от получения и использования данной информации потребителем. Проблемы этого уровня связаны с определением ценности и полезности использования информации при выработке потребителем решения для достижения своей цели. Основная сложность здесь состоит в том, что ценность, полезность информации может быть совершенно различной для различных получателей и, кроме того, она зависит от ряда факторов, таких, например, как своевременность ее доставки и использования.

Для каждого из рассмотренных выше уровней проблем передачи информации существуют свои подходы к измерению количества информации и свои меры информации. Различают соответственно меры информации синтаксического уровня, семантического уроня и прагматического уровня.

Меры информации синтаксического уровня. Количественная оценка информации этого уровня не связана с содержательной стороной информации, а оперирует с обезличенной информацией, не выражающей смыслового отношения к объекту. В связи с этим данная мера дает возможность оценки информационных потоков в таких разных по своей природе объектах, как системы связи, вычислительные машины, системы управления, нервная система живого организма и т. п.

Для измерения информации на синтаксическом уровне вводятся два параметра: объем информации (данных) – V д (объемный подход) и количество информации – I (энтропийный подход).

Объем информацииV д (объемный подход). При реализации информационных процессов информация передается в виде сообщения, представляющего собой совокупность символов какого-либо алфавита. При этом каждый новый символ в сообщении увеличивает количество информации, представленной последовательностью символов данного алфавита. Если теперь количество информации, содержащейся в сообщении из одного символа, принять за единицу, то объем информации (данных) V д в любом другом сообщении будет равен количеству символов (разрядов) в этом сообщении. Так как одна и та же информация может быть представлена многими разными способами (с использованием разных алфавитов), то и единица измерения информации (данных) соответственно будет меняться.

Так, в десятичной системе счисления один разряд имеет вес, равный 10, и соответственно единицей измерения информации будет дит (десятичный разряд п п дит. Например, четырехразрядное число 2009 имеет объем данных V д = 4 дит.

В двоичной системе счисления один разряд имеет вес, равный 2, и соответственно единицей измерения информации будет бит (bit (binary digit) – двоичный разряд ). В этом случае сообщение в виде n -разрядного числа имеет объем данных V д = п бит. Например, восьмиразрядный двоичный код 11001011 имеет объем данных V д = 8 бит.

В современной вычислительной технике наряду с минимальной единицей измерения данных бит широко используется укрупненная единица измерения байт , равная 8 бит. Именно восемь битов требуется для того, чтобы закодировать любой из 256 символов алфавита клавиатуры компьютера (256=2 8).

При работе с большими объемами информации для подсчета ее количества применяют более крупные единицы измерения:

1 Килобайт (Кбайт) = 1024 байт = 2 10 байт,

1 Мегабайт (Мбайт) = 1024 Кбайт = 2 20 байт = 1 048 576 байт;

1 Гигабайт (Гбайт) = 1024 Мбайт = 2 30 байт = 1 073 741 824 байт;

В последнее время в связи с увеличением объёмов обрабатываемой информации входят в употребление такие производные единицы, как:

1 Терабайт (Тбайт) = 1024 Гбайт = 2 40 байт = 1 099 511 627 776 байт;

1 Петабайт (Пбайт) = 1024 Тбайт = 2 50 байт = 1 125 899 906 842 624 байт.

Следует обратить внимание, что в системе измерения двоичной (компьютерной) информации, в отличие от метрической системы, единицы с приставками «кило», «мега» и т. д. получаются путем умножения основной единицы не на 10 3 = 1000, 10 6 = 1 000 000 и т. д., а на 2 10 = 1024, 2 20 = 1 048 576 и т. д.

Количество информации I (энтропийный подход). В теории информации и кодирования принят энтропийный подход к измерению информации. Этот подход основан на том, что факт получения информации всегда связан с уменьшением разнообразия или неопределенности (энтропии) системы. Исходя из этого, количество информации в сообщении определяется как мера уменьшения неопределенности состояния данной системы после получения сообщения. Неопределенность может быть интерпретирована в смысле того, насколько мало известно наблюдателю о данной системе. Как только наблюдатель выявил что-нибудь в физической системе, энтропия системы снизилась, так как для наблюдателя система стала более упорядоченной.

Таким образом, при энтропийном подходе под информацией понимается количественная величина исчезнувшей в ходе какого-либо процесса (испытания, измерения и т.д.) неопределенности. При этом в качестве меры неопределенности вводится энтропия Н , а количество информации равно:

I = H apr – H aps

где, H apr – априорная энтропия о состоянии исследуемой системы или процесса;

H aps – апостериорная энтропия.

Апостериори (от лат. a posteriori – из последующего ) – происходящее из опыта (испытания, измерения).

Априори (от лат. a priori – из предшествующего ) – понятие, характеризующее знание, предшествующее опыту (испытанию), и независимое от него.

В случае, когда в ходе испытания имевшаяся неопределенность снята (получен конкретный результат, т. е. Н = 0), количество полученной информации совпадает с первоначальной энтропией

Рассмотрим в качестве исследуемой системы дискретный источник информации (источник дискретных сообщений), под которым будем понимать физическую систему, имеющую конечное множество возможных состояний {а i }, i = .

Все множество А = {a 1 , a 2 , ..., а n } состояний системы в теории информации называют абстрактным алфавитом или алфавитом источника сообщений.

Отдельные состояния a 1 , а 2 ,..., а n называют буквами или символами алфавита.

Такая система может в каждый момент времени случайным образом принять одно из конечных множеств возможных состояний a i . При этом говорят, что различные состояния реализуются вследствие выбора их источником.

Получатель информации (сообщения) имеет определенное представление о возможных наступлениях некоторых событий. Эти представления в общем случае недостоверны и выражаются вероятностями, с которыми он ожидает то или иное событие. Общая мера неопределенности (энтропия) характеризуется некоторой математической зависимостью от этих вероятностей, количество информации в сообщении определяется тем, насколько уменьшается мера неопределенности после получения сообщения.

Поясним эту идею на примере.

Пусть у нас имеется 32 различные карты. Возможность выбора одной карты из колоды – 32. До произведения выбора, естественно предложить, что шансы выбрать некоторую определенную карту, одинаковы для всех карт. Произведя выбор, мы устраняем эту неопределенность. При этом неопределенность можно охарактеризовать количеством возможных равновероятностных выборов. Если теперь определить количество информации как меру устранения неопределенности, то полученную в результате выбора информацию можно охарактеризовать числом 32. Однако удобнее использовать не само это число, а логарифм от полученной выше оценки по основанию 2:

где m – число возможных равновероятных выборов (При m=2, получим информацию в один бит). То есть в нашем случае

H = log 2 32 = 5.

Изложенный подход принадлежит английскому математику Р. Хартли (1928 г.). Он имеет любопытную интерпретацию. Он характеризуется числом вопросов с ответами «да» или «нет», позволяющим определить, какую карту выбрал человек. Таких вопросов достаточно 5.

Если при выборе карты, возможность появления каждой карты не одинаковы (разновероятны), то получим статистический подход к измерению информации, предложенный К. Шенноном (1948 г.). В этом случае мера информации измеряется по формуле:

где p i – вероятность выбора i -го символа алфавита.

Легко заметить, что если вероятности p 1 , ..., p n равны, то каждая из них равна 1/N , и формула Шеннона превращается в формулу Хартли.

Меры информации семантического уровня. Для измерения смыслового содержания информации, т. е. ее количества на семантическом уровне, наибольшее распространение получила тезаурусная мера, которая связывает семантические свойства информации со способностью пользователя принимать поступившее сообщение. Действительно, для понимания и использования полученной информации получатель должен обладать определенным запасом знаний. Полное незнание предмета не позволяет извлечь полезную информацию из принятого сообщения об этом предмете. По мере роста знаний о предмете растет и количество полезной информации, извлекаемой из сообщения.

Если назвать имеющиеся у получателя знания о данном предмете тезаурусом (т. е. неким сводом слов, понятий, названий объектов, связанных смысловыми связями), то количество информации, содержащееся в некотором сообщении, можно оценить степенью изменения индивидуального тезауруса под воздействием данного сообщения.

Тезаурус - совокупность сведений, которыми располагает пользователь или система.

Иными словами, количество семантической информации, извлекаемой получателем из поступающих сообщений, зависит от степени подготовленности его тезауруса для восприятия такой информации.

В зависимости от соотношений между смысловым содержанием информации S и тезаурусом пользователя S p изменяется количество семантической информации I с , воспринимаемой пользователем и включаемой им в дальнейшем в свой тезаурус. Характер такой зависимости показан на рис. 2.1. Рассмотрим два предельных случая, когда количество семантической информации I с равно 0:

а) при S p = 0 пользователь не воспринимает (не понимает) поступающую информацию;

б) при S -> ∞ пользователь «все знает», и поступающая информация ему не нужна.

Рис. 1.2. Зависимость количества семантической информации,

воспринимаемой потребителем, от его тезауруса I c =f(S p)

Максимальное количество семантической информации потребитель приобретает при согласовании ее смыслового содержания S со своим тезаурусом S p (S = S p opt), когда поступающая информация понятна пользователю и несет ему ранее неизвестные (отсутствующие в его тезаурусе) сведения.

Следовательно, количество семантической информации в сообщении, количество новых знаний, получаемых пользователем, является величиной относительной. Одно и то же сообщение может иметь смысловое содержание для компетентного пользователя и быть бессмысленным для пользователя некомпетентного.

При оценке семантического (содержательного) аспекта информации необходимо стремиться к согласованию величин S и Sp.

Относительной мерой количества семантической информации может служить коэффициент содержательности С, который определяется как отношение количества семантической информации к ее объему:

С = I с / V д

Меры информации прагматического уровня. Эта мера определяет полезность информации для достижения пользователем поставленной цели. Эта мера также величина относительная, обусловленная особенностями использования этой информации в той или иной системе.

Одним из первых российских ученых к проблеме оценки информации прагматического уровня обратился А.А. Харкевич, который предложил принять за меру ценности информации количество информации, необходимое для достижения поставленной цели, т. е. рассчитывать приращение вероятности достижения цели. Так, если до получения информации вероятность достижения цели равнялась р 0 , а после ее получения – p 1 то ценность информации определяется как логарифм отношения p 1 /p 0:

I = log 2 p 1 – log 2 р 0 = log 2 (p 1 /p 0)

Таким образом, ценность информации при этом измеряется в единицах информации, в данном случае в битах.